Más Información

Buen 2024 para las reservas internacionales; con 229 mil mdd se perfilan para cerrar uno de sus mejores años

Cae mujer que arrojó aceite caliente a vendedoras de comida en Veracruz; hecho causó indignación en redes sociales

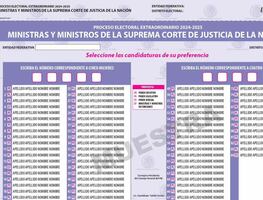

INE aprueba 4 diseños de boletas para elección del Poder Judicial; pendientes las de jueces y magistrados

VIDEO El High Energy inunda Paseo de la Reforma; cientos de personas sacan sus mejores pasos previo a la presentación de Polymarchs

En 24 horas, Gabinete de Seguridad detiene a 19 personas en diferentes acciones; aseguran armas de fuego y drogas

Detienen a sujeto con 2 maletas en Sinaloa; transportaba 54 paquetes de fentanilo y dosis de cristal

The New York Times respalda su investigación sobre fentanilo; “Nuestros periodistas pasaron meses investigando”

Londres.- La inteligencia artificial (IA) plantea un "riesgo de extinción" comparable al de las pandemias o la guerra nuclear, adviertió este martes en una carta un grupo de más de 300 expertos e investigadores de la industria.

Científicos y directivos de Microsoft, Google y otras empresas de la industria tecnológica emitieron una nueva advertencia acerca de los peligros que representa la inteligencia artificial para la humanidad.

“Mitigar el riesgo de extinción de la IA debería ser una prioridad global junto con otros riesgos a escala social, tales como las pandemias y la guerra nuclear”, dice el comunicado publicado online.

Sam Altman, director general de OpenAI, fabricante de ChatGPT, y el científico Geoffrey Hinton, considerado el padrino de la inteligencia artificial, están entre los cientos de personalidades destacadas que firmaron la declaración, publicada en el sitio web de Center for AI Safety (centro por la seguridad de la IA).

También están el director ejecutivo de Google DeepMind, Demis Hassabis; Dario Amodei, director ejecutivo de Anthropic, y Youshua Bengio, dos de los tres investigadores de IA que ganaron el Premio Turing 2018 -conocido popularmente como el Premio Nobel de la informática- por su trabajo en IA.

Los temores de que sistemas de inteligencia artificial se vuelvan más inteligentes que el ser humano y escapen a todo control se han intensificado con la aparición de una nueva generación de chatbots altamente capacitados como ChatGPT.

Leen también ¿Cuáles son los riesgos de la inteligencia artificial, según Geoffrey Hinton?

Aumenta temor porque IA se vuelva más inteligente que los humanos

La advertencia más reciente fue intencionalmente lacónica -apenas una frase- para abarcar a una coalición amplia de científicos que podrían no estar de acuerdo sobre los riesgos más probables o las mejores soluciones para prevenirlos, dijo Dan Hendrycks, director general del Center for AI Safety, con sede en San Francisco.

“Una variedad de personas de todas las universidades principales y diversas disciplinas están preocupadas por esto y piensan que es una prioridad global”, dijo Hendrycks. “Por eso tuvimos que conseguir gente que saliera de las sombras, por así decir, para hablar sobre esto porque muchos hablaban en silencio entre ellos”.

Lee también ¿Lava del volcán Popocatépetl llegaría a CDMX en caso de erupción? IA responde en TikTok

En marzo, más de mil investigadores y tecnólogos, entre ellos Elon Musk, habían firmado una carta mucho más larga para pedir una pausa de seis meses en el desarrollo de la IA porque crea “profundos riesgos para la sociedad y la humanidad”.

Países en todo el mundo se apresuran a elaborar regulaciones para el desarrollo de la tecnología. La Unión Europea abre el camino con su Ley de IA, que espera aprobar en los próximos meses.

En este mes, mayo, Altman, Hassabis y Amodei se reunieron con el presidente de Estados Unidos, Joe Biden, y la vicepresidenta, Kamala Harris, para hablar sobre la regulación de la AI.

Además, el director ejecutivo de OpenAI testificó ante el Senado estadounidense y advirtió que los riesgos de esta tecnología eran lo suficientemente serios como para justificar la intervención del gobierno.

Leen también Llegó el futuro: Neuralink, empresa de Elon Musk, recibe permiso para ensayar implantes cerebrales en humanos

mcc